AI技術の進化に伴い、生成AIであるChatGPTの活用が広がっています。しかし、その利便性の一方で、セキュリティや倫理面でのリスクも無視できません。本記事では、ChatGPTを含む生成AIを安全に利用するためのリスクと具体的な対策を解説します。企業や個人の安全なAI利用に役立つ情報を提供しますので、ぜひ参考にしてください。

1. 生成AIに潜むリスク

生成AIは非常に強力なツールですが、その力の裏にはいくつかのリスクも潜んでいます。これらのリスクは大きく分けて、利用者にとってのリスクと社会全体にとってのリスクに分類できます。

1.1 利用者にとってのリスク

- 情報漏えい

ChatGPTをはじめとする生成AIツールは、ユーザーが入力したデータを学習に使用する場合があります。特に機密情報を入力すると、その情報が他者に露出する可能性があるため、注意が必要です。また、フィッシング詐欺など、悪意ある第三者による情報の搾取も増加しているため、公式サイトやアプリの利用を徹底することが重要です。 - 誤情報の生成(ハルシネーション)

生成AIの出力が必ずしも正確であるとは限らず、時には誤った情報(ハルシネーション)を生成することがあります。この誤情報をそのまま信じて利用すると、ビジネス上の判断ミスや不正確な情報の拡散につながる可能性があります。 - 倫理的に問題のある表現の生成

AIの出力には、差別的な表現や偏見を含む内容が生成される可能性があります。これにより、ブランドイメージの低下や法的リスクが生じることがあります。

1.2 社会にとってのリスク

- 権利侵害

生成AIは、著作権のあるコンテンツを学習データとして使用することがあるため、意図せず著作権を侵害する可能性があります。AIが生成した文章や画像をそのまま使用すると、法的なトラブルに発展するリスクがあります。 - サイバー攻撃の増加

生成AIを悪用して、フィッシングメールやマルウェアを作成し、サイバー攻撃を行うケースが報告されています。これにより、個人情報の漏洩や企業のセキュリティが脅かされる事態が生じています。

2. 企業が講じておきたい生成AIのリスクへの対策

生成AIのリスクに対処するためには、企業として以下のような対策を講じることが重要です。

2.1 情報漏えいへの対策

生成AIを使う際には、機密情報の入力を避けることが基本です。特にWeb版のAIツールを利用する際には、情報が他者に露出するリスクを考慮し、データの取り扱いには慎重を期すべきです。また、API版やエンタープライズプランの利用を検討することで、より安全に情報を管理できます。

2.2 誤情報の生成(ハルシネーション)への対策

生成AIの回答をそのまま利用せず、必ず専門家のレビューを通すことが重要です。特に医療や法務など、専門知識を要する分野では、AIの出力を信頼するのではなく、専門家の監修を受けることで誤情報のリスクを減らせます。

2.3 倫理的に問題のある表現の生成への対策

AIの出力を監視し、差別的な表現や不適切なコンテンツが含まれていないか確認する仕組みを整えましょう。必要に応じて、AIの利用に関するポリシーを設定し、倫理的なコンテンツ生成を推進することが求められます。

2.4 権利侵害への対策

生成AIを使用する際には、著作権やその他の権利を侵害しないように注意が必要です。生成されたコンテンツを利用する前に、必ず権利の確認を行い、第三者のコンテンツを利用しないよう心がけましょう。

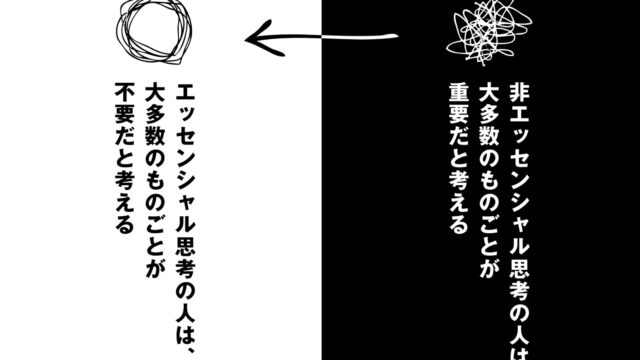

2.5 共通:社内での生成AI利用のルールを決めておく

生成AIを安全に活用するためには、社内での利用ルールを明確に定めることが不可欠です。情報の取り扱いや利用目的、責任範囲を明確にし、従業員全員が同じ理解を持ってAIを活用する体制を整えましょう。

3. 生成AIのビジネスにおける活用方法

生成AIは、リスクを管理しつつもビジネスにおいて大いに活用できるツールです。例えば、マーケティングにおけるコンテンツ生成、カスタマーサポートの効率化、データ分析の補助など、多岐にわたる活用方法が考えられます。AIの特性を理解し、適切な場面で使うことで、業務の効率化や新しい価値の創出につなげることができます。

4. まとめ

生成AI、特にChatGPTを含むAIツールの活用は、ビジネスの効率化や新しい価値の創出に大きく貢献します。しかし、その一方で、セキュリティリスクや倫理的な問題も存在するため、慎重な利用が求められます。企業や個人がこれらのリスクを理解し、適切な対策を講じることで、生成AIを安全に、そして効果的に活用することが可能になります。

生成AIを安全に使いこなし、未来のビジネスを切り拓くために、今後も新たなリスクと対策を常に考慮し続けることが大切です。